iOS10语音识别框架SpeechFramework应用

一、引言

iOS10系统是一个较有突破性的系统,其在Message,Notification等方面都开放了很多实用性的开发接口。本篇博客将主要探讨iOS10中新引入的SpeechFramework框架。有个这个框架,开发者可以十分容易的为自己的App添加语音识别功能,不需要再依赖于其他第三方的语音识别服务,并且,Apple的Siri应用的强大也证明了Apple的语音服务是足够强大的,不通过第三方,也大大增强了用户的安全性。

二、SpeechFramework框架中的重要类

SpeechFramework框架比较轻量级,其中的类并不十分冗杂,在学习SpeechFramework框架前,我们需要对其中类与类与类之间的关系有个大致的熟悉了解。

SFSpeechRecognizer:这个类是语音识别的操作类,用于语音识别用户权限的申请,语言环境的设置,语音模式的设置以及向Apple服务发送语音识别的请求。

SFSpeechRecognitionTask:这个类是语音识别服务请求任务类,每一个语音识别请求都可以抽象为一个SFSpeechRecognitionTask实例,其中SFSpeechRecognitionTaskDelegate协议中约定了许多请求任务过程中的监听方法。

SFSpeechRecognitionRequest:语音识别请求类,需要通过其子类来进行实例化。

SFSpeechURLRecognitionRequest:通过音频URL来创建语音识别请求。

SFSpeechAudioBufferRecognitionRequest:通过音频流来创建语音识别请求。

SFSpeechRecognitionResult:语音识别请求结果类。

SFTranscription:语音转换后的信息类。

SFTranscriptionSegment:语音转换中的音频节点类。

了解了上述类的作用于其之间的联系,使用SpeechFramework框架将十分容易。

三、申请用户语音识别权限与进行语音识别请求

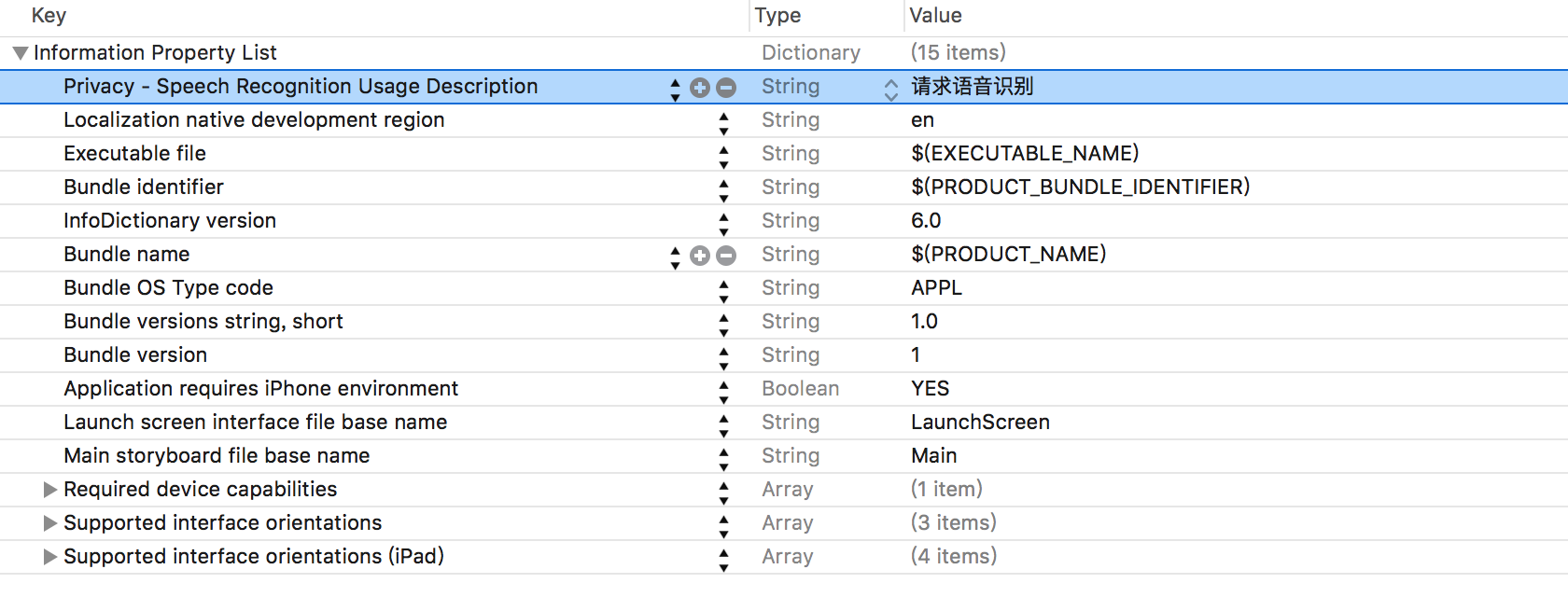

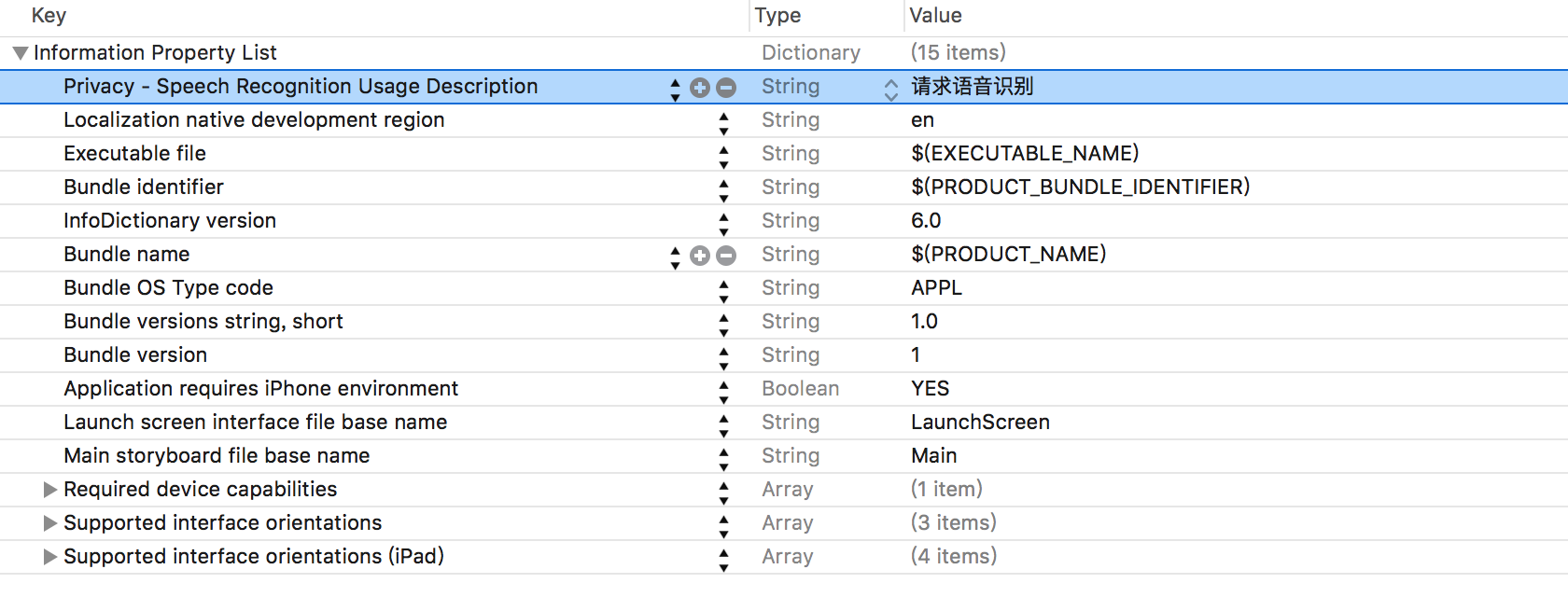

开发者若要在自己的App中使用语音识别功能,需要获取用户的同意。首先需要在工程的Info.plist文件中添加一个Privacy-Speech Recognition Usage Description键,其实需要对应一个String类型的值,这个值将会在系统获取权限的警告框中显示,Info.plist文件如下图所示:

使用SFSpeechRecognize类的requestAuthorization方法来进行用户权限的申请,用户的反馈结果会在这个方法的回调block中传入,如下:

1

2

3

|

[SFSpeechRecognizer requestAuthorization:^(SFSpeechRecognizerAuthorizationStatus status) {

}];

|

SFSpeechRecognizerAuthorzationStatus枚举中定义了用户的反馈结果,如下:

1

2

3

4

5

6

7

8

9

10

| typedef NS_ENUM(NSInteger, SFSpeechRecognizerAuthorizationStatus) {

SFSpeechRecognizerAuthorizationStatusNotDetermined,

SFSpeechRecognizerAuthorizationStatusDenied,

SFSpeechRecognizerAuthorizationStatusRestricted,

SFSpeechRecognizerAuthorizationStatusAuthorized,

};

|

如果申请用户语音识别权限成功,开发者可以通过SFSpeechRecognizer操作类来进行语音识别请求,示例如下:

1

2

3

4

5

6

7

8

9

|

SFSpeechRecognizer * rec = [[SFSpeechRecognizer alloc]init];

SFSpeechRecognitionRequest * request = [[SFSpeechURLRecognitionRequest alloc]initWithURL:[[NSBundle mainBundle] URLForResource:@"7011" withExtension:@"m4a"]];

[rec recognitionTaskWithRequest:request resultHandler:^(SFSpeechRecognitionResult * _Nullable result, NSError * _Nullable error) {

NSLog(@"%@",result.bestTranscription.formattedString);

}];

|

四、深入SFSpeechRecognizer类

SFSpeechRecognizer类的主要作用是申请权限,配置参数与进行语音识别请求。其中比较重要的属性与方法如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

|

+ (SFSpeechRecognizerAuthorizationStatus)authorizationStatus;

+ (void)requestAuthorization:(void(^)(SFSpeechRecognizerAuthorizationStatus status))handler;

+ (NSSet<NSLocale *> *)supportedLocales;

- (nullable instancetype)init;

- (nullable instancetype)initWithLocale:(NSLocale *)locale NS_DESIGNATED_INITIALIZER;

@property (nonatomic, readonly, getter=isAvailable) BOOL available;

@property (nonatomic, weak) id<SFSpeechRecognizerDelegate> delegate;

@property (nonatomic) SFSpeechRecognitionTaskHint defaultTaskHint;

- (SFSpeechRecognitionTask *)recognitionTaskWithRequest:(SFSpeechRecognitionRequest *)request

resultHandler:(void (^)(SFSpeechRecognitionResult * __nullable result, NSError * __nullable error))resultHandler;

- (SFSpeechRecognitionTask *)recognitionTaskWithRequest:(SFSpeechRecognitionRequest *)request

delegate:(id <SFSpeechRecognitionTaskDelegate>)delegate;

@property (nonatomic, strong) NSOperationQueue *queue;

|

SFSpeechRecognizerDelegate协议中只约定了一个方法,如下:

1

2

|

- (void)speechRecognizer:(SFSpeechRecognizer *)speechRecognizer availabilityDidChange:(BOOL)available;

|

通过Block回调的方式进行语音识别请求十分简单,如果使用代理回调的方式,开发者需要实现SFSpeechRecognitionTaskDelegate协议中的相关方法,如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

- (void)speechRecognitionDidDetectSpeech:(SFSpeechRecognitionTask *)task;

- (void)speechRecognitionTask:(SFSpeechRecognitionTask *)task didHypothesizeTranscription:(SFTranscription *)transcription;

- (void)speechRecognitionTask:(SFSpeechRecognitionTask *)task didFinishRecognition:(SFSpeechRecognitionResult *)recognitionResult;

- (void)speechRecognitionTaskFinishedReadingAudio:(SFSpeechRecognitionTask *)task;

- (void)speechRecognitionTaskWasCancelled:(SFSpeechRecognitionTask *)task;

- (void)speechRecognitionTask:(SFSpeechRecognitionTask *)task didFinishSuccessfully:(BOOL)successfully;

|

SFSpeechRecognitionTask类中封装了属性和方法如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

@property (nonatomic, readonly) SFSpeechRecognitionTaskState state;

@property (nonatomic, readonly, getter=isFinishing) BOOL finishing;

- (void)finish;

@property (nonatomic, readonly, getter=isCancelled) BOOL cancelled;

- (void)cancel;

|

关于音频识别请求类,除了可以使用SFSpeechURLRecognitionRequest类来进行创建外,还可以使用SFSpeechAudioBufferRecognitionRequest类来进行创建:

1

2

3

4

5

6

7

8

9

10

| @interface SFSpeechAudioBufferRecognitionRequest : SFSpeechRecognitionRequest

@property (nonatomic, readonly) AVAudioFormat *nativeAudioFormat;

- (void)appendAudioPCMBuffer:(AVAudioPCMBuffer *)audioPCMBuffer;

- (void)appendAudioSampleBuffer:(CMSampleBufferRef)sampleBuffer;

- (void)endAudio;

@end

|

五、语音识别结果类SFSpeechRecognitionResult

SFSpeechRecognitionResult类是语音识别结果的封装,其中包含了许多套平行的识别信息,其每一份识别信息都有可信度属性来描述其准确程度。SFSpeechRecognitionResult类中属性如下:

1

2

3

4

5

6

|

@property (nonatomic, readonly, copy) NSArray<SFTranscription *> *transcriptions;

@property (nonatomic, readonly, copy) SFTranscription *bestTranscription;

@property (nonatomic, readonly, getter=isFinal) BOOL final;

|

SFSpeechRecognitionResult类只是语音识别结果的一个封装,真正的识别信息定义在SFTranscription类中,SFTranscription类中属性如下:

1

2

3

4

|

@property (nonatomic, readonly, copy) NSString *formattedString;

@property (nonatomic, readonly, copy) NSArray<SFTranscriptionSegment *> *segments;

|

当对一句完整的话进行识别时,Apple的语音识别服务实际上会把这句语音拆分成若干个音频节点,每个节点可能为一个单词,SFTranscription类中的segments属性就存放这些节点。SFTranscriptionSegment类中定义的属性如下:

1

2

3

4

5

6

7

8

9

10

11

12

|

@property (nonatomic, readonly, copy) NSString *substring;

@property (nonatomic, readonly) NSRange substringRange;

@property (nonatomic, readonly) NSTimeInterval timestamp;

@property (nonatomic, readonly) NSTimeInterval duration;

@property (nonatomic, readonly) float confidence;

@property (nonatomic, readonly) NSArray<NSString *> *alternativeSubstrings;

|

温馨提示:SpeechFramework框架在模拟器上运行会出现异常情况,无法进行语音识别请求。会报出kAFAssistantErrorDomain的错误,还望有知道解决方案的朋友,给些建议,Thanks。

专注技术,热爱生活,交流技术,也做朋友。

——珲少 QQ群:203317592